前段时间,我曾经介绍过Imagen Video模型。它能够在输入一句话中,生成5~6秒的视频。而且由于采用了“空间高分辨率模型”和“时域高分辨率模型”的级联模型,它能够清晰度在1280×768的高清视频。具体的介绍可以回看我之前写的文章:

虽然Imagen Video模型,能够生成高清晰度的短视频,但是仅仅只有5秒左右的时间,因此实际的用处并不到。为了克服这个缺点,谷歌也进一步发布了Phenaki模型。

Phenaki

这个模型不同点在于,它能够根据200个词语,生成2分钟以上的视频。

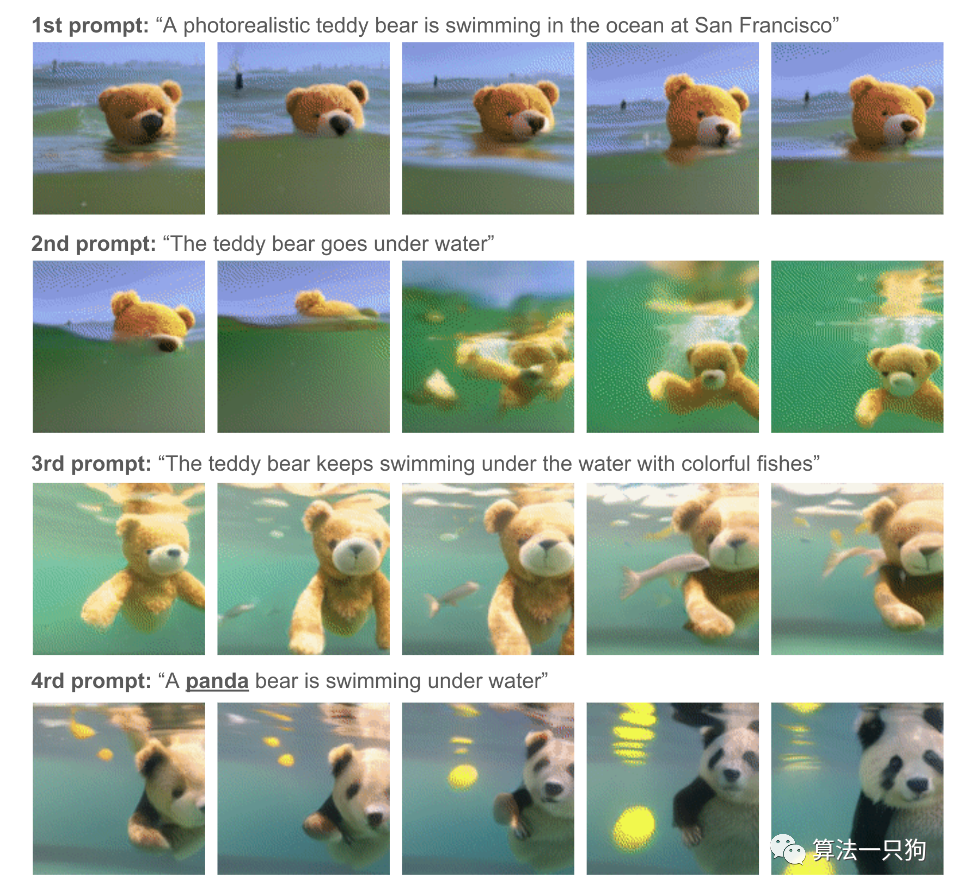

比如输入文字:

一只逼真的泰迪熊正在旧金山的海里游泳

泰迪熊下水了

泰迪熊和五颜六色的鱼在水下游泳

一只熊猫在水下游泳

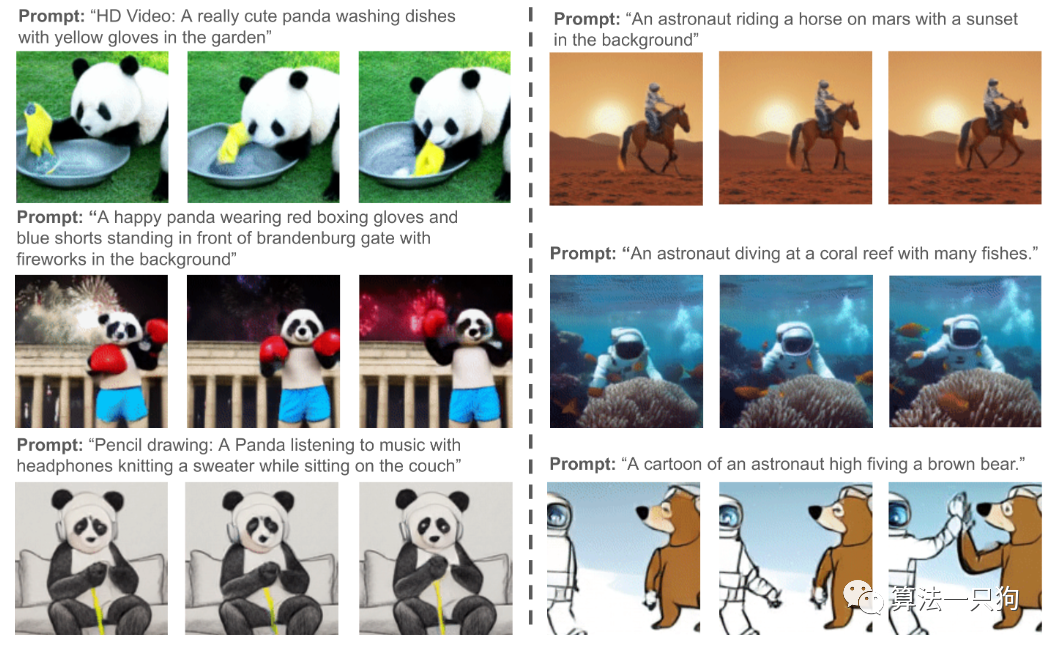

或者输入“泰迪熊在海洋中潜水”、“宇航员在火星上跳舞”等词语,可以生成下面的短视频:

同时该模型在修改prompt提示词语的时候,也能够生成不一样的短视频:

技术细节

谷歌新提出的Phenaki,主要是引入了一个新的causal model。这个模型从离散的tokens去压缩视频,使得模型能够克服视频长度的问题。

如下图所示,它能够根据超长的prompt去生成每一秒的视频:

同时分词器使用了causal attention,这使得它能够处理可变长度的视频。为了从文本生成视频tokens,论文中使用了一个基于预先计算的文本标记的双向掩码transformer。

生成的视频tokens随后被去标记化以创建实际视频。同时为了解决数据问题,论文中使用了大量图像-文本对语料库以及少量视频-文本示例上进行联合训练,从而实现超出视频数据集可用范围的泛化。

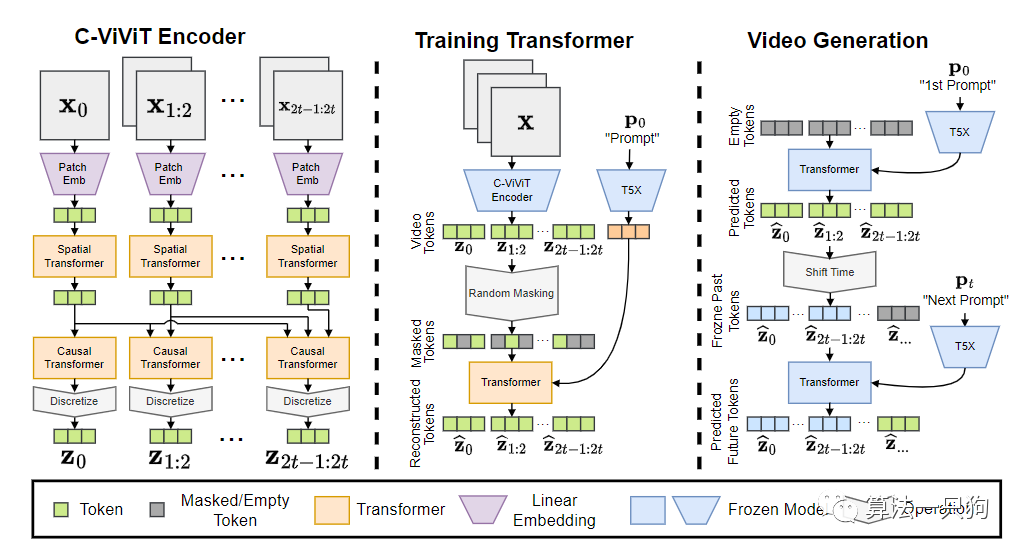

先来看一下具体的模型结构

- C-ViViT Encoder:把输入的视频构造成离散的embedding进行输出

- Traning Transformer:使用了预训练模型T5X,把embedding翻译成视频tokens

- Video Generation:把视频tokens转换成视频

1

Encoder-Decoder架构:C-VIVIT

在Phenaki中,由于目标是生成可变长度的视频,同时将视频tokerns的数量保持在最小,以便在当前的计算限制范围内使用transformer对其进行建模。

因此引入了C-ViViT,这是ViViT的一种casual结构,它可以在时间和空间维度上压缩视频,同时保持时间上的自回归。这种能力允许任意长度生成视频

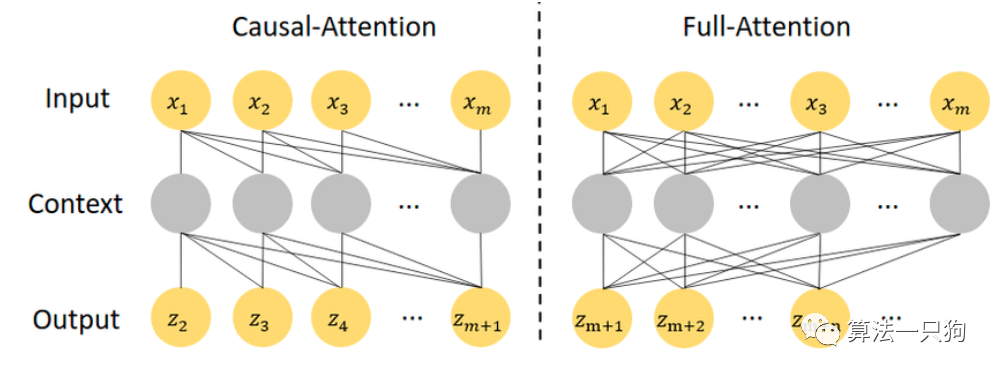

casual attention如上所示。本质上就是,每个时间步的tokens仅以自回归方式观察来自先前帧的空间标记。这样做的效果是第一帧可以完全独立地编码。这为文本到图像训练自然嵌入到视频模型中提供了可能性。第二个优点是,我们可以根据起始帧的数量来调节视频生成过程。

2

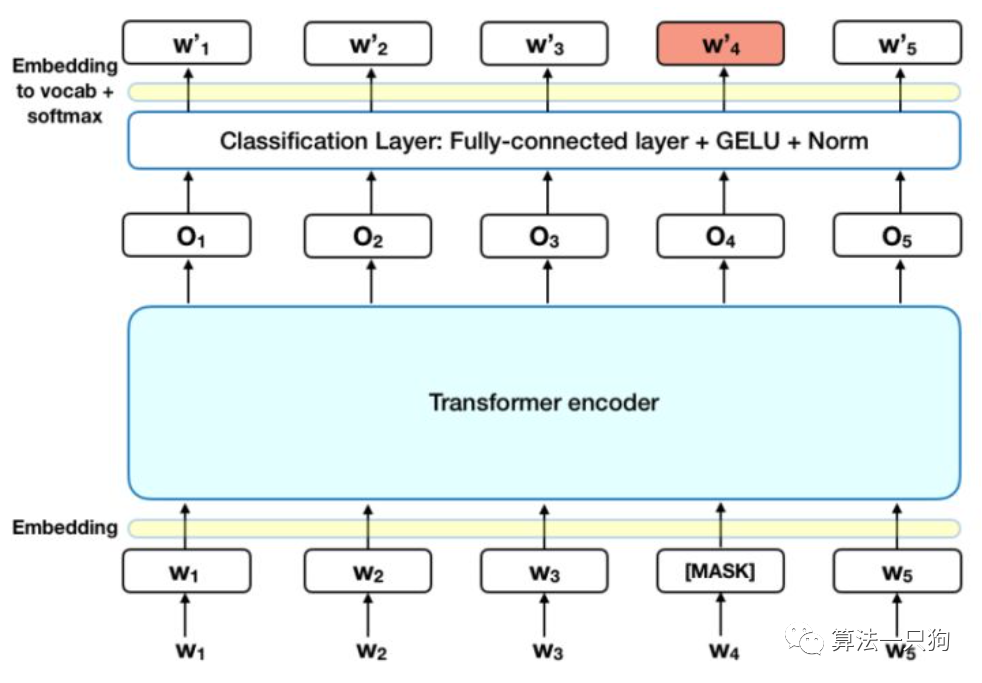

双向Transformer

在这个任务里面,可以把文本到视频当作是一个seq-to-seq的任务。即可以从文本预测视频tokerns。

同时对长视频进行随机采样,这样可以有效减少预测的时间步,提高计算效率。

对于训练来说,从0~1之间随机选择一个mask比率,把一定的时间步用[MASK]替换掉,然后在训练的时候则可以预测这些标签。

从实验效果上看,可以生成不同风格的视频。

文本生成视频所带来的问题

视频生成模型可以用来对社会产生积极影响,例如通过放大和增强人类的创造力。然而,这些生成模式也可能被滥用,例如生成虚假、仇恨、明确或有害的内容。

同时,新的AI技术带来的行业革新也在悄悄的发生。比如未来可以利用这些模型合成短视频,发布的短视频平台上。到时候你看到的视频,有可能已经不是真人视频了。

好了,本期就到这里了,我是leo,欢迎关注我的知乎/公众号“算法一只狗”,我们下期再见~

木盒主机

木盒主机 搬瓦工VPS最新优惠码 搬瓦工最高优惠6.81%优惠码 promo coupon code

搬瓦工VPS最新优惠码 搬瓦工最高优惠6.81%优惠码 promo coupon code  RackNerd:美国VPS 黑五优惠折扣 1核768RAM $10.28/年+神秘盒子 可随机减免金额

RackNerd:美国VPS 黑五优惠折扣 1核768RAM $10.28/年+神秘盒子 可随机减免金额 10G.BIZ【年终钜惠】美国/日本/韩国/香港独立服务器 秒杀仅24起,站群仅需99,三网CN2GIA五折抢购。CERA洛杉矶云服务器仅2.4起

10G.BIZ【年终钜惠】美国/日本/韩国/香港独立服务器 秒杀仅24起,站群仅需99,三网CN2GIA五折抢购。CERA洛杉矶云服务器仅2.4起 2022年RackNerd 美国VPS促销:4TB月流量11.88美元/年,支持支付宝,老优惠$9.89美元/年

2022年RackNerd 美国VPS促销:4TB月流量11.88美元/年,支持支付宝,老优惠$9.89美元/年